提到敏捷交付,我们总会说到持续集成,持续交付,持续发布,即频繁地交付产品特性。而我们都知道要实现真正的持续交付,必然少不了两个关键要素:

持续集成工具

自动化测试不只自动化工具可以开门见山地说:AutomationTest≠AutomationTools≠ContinuousTest

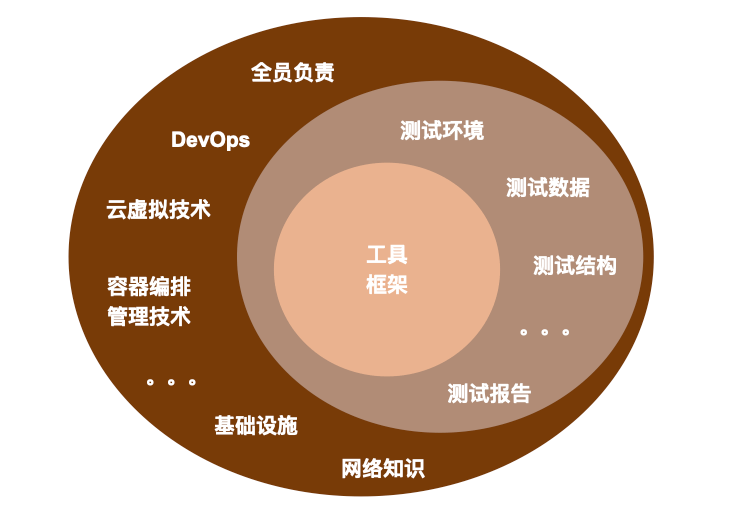

根据我个人的项目经验,试着画了下面这个图来表达这三者的关系。

在提及自动化测试的时候,很多人会把工具的使用等同于自动化测试。自动化测试应该是一个策略性的系统工程,不只有自动化工具。像我们的产品一样,不仅要有技术语言,还要有产品架构设计。自动化测试除了工具框架,还需要考虑:

项目的技术栈,产品架构,开发流程,基础设施,可靠的测试数据,稳定干净的测试环境,如何呈现测试报告,如何工程化测试配置,测试套件等等。

维基百科对自动化的解释:

Insoftwaretesting,testautomationistheuseofsoftwareseparatefromthesoftwarebeingtestedtocontroltheexecutionoftestsandthecomparisonofactualoutcomeswithpredictedoutcomes.

从定义可以总结出自动化测试的两个特点:

自动化测试本身也是软件

自动化测试基于预期结果进行断言

测试,质量评估的重要手段之一,而自动化测试只是测试的一种具体实现方式而已。它能释放QA的双手和一部分大脑(这部分大脑,即knowknowns),将对已知特性和既定逻辑流程的检测交由计算机来完成。而QA去做更多需要思辨能力,分析判断能力的事情。例如,通过向团队提问,来澄清需求的unknowns;通过探索产品去拓宽对产品的knowns;抑或运用经验帮助团队走出UnknownUnknowns带来的迷局。

维基百科对持续测试的解释:

Continuoustestingistheprocessofexecutingautomatedtestsaspartofthesoftwaredeliverypipelinetoobtainimmediatefeedbackonthebusinessrisksassociatedwithasoftwarereleasecandidate.

想强调定义里的几个关键字:automatedtests,deliverypipeline,immediatefeedback,businessrisks.

测试工具的选择需要考虑项目的技术栈,也需要考虑QA自身的技术能力。不管多火的工具,如果不能兼容项目的技术栈和基础设施,那都无处发挥其优势,流行的不一定是适合项目的。

在写自动化之前,QA需要对项目的技术栈,开发流程,和基础设施有基本的认识和了解;另外也需要了解和掌握各个工具之间的优劣,这样才能为项目选择最匹配的自动化工具。是不是像老生常谈?但是别人告诉你的经验和自己经历的实战真的两种不同的收获。就跟蹲家看电视和去现场看演唱会的区别一样,别人的经验之谈总归是别人的,自己走过的路才是自己的。

这两年Cypress真的很火,去年在项目上做UI自动化测试的时候,出于好奇也想实践一把。实践出真知,Cypress本身可以通过环境变量和plugin配置代理,但是不支持socks5的代理(客观现状是项目所有资产,包括测试环境都是通过socks5的代理连接),线上环境无法访问。当时还试过将socks5的代理转换成http代理,但因为Cypress本身是多线程的,而socks5只能截获第一个进程的网络通信,即使能连通应用本身,Cypress也无法将测试过程可视化的优势发挥出来。人无完人,工具也一样,只有适合你的才是好的。

考虑自己也不会造轮子,喜欢拿来就用,加之项目上socks5代理约束,之后便转用了CodeceptJS,几次尝试下来,觉得非常满足项目需要。下面罗列CodeceptJS几个好用的点,具体细节请移步官网。

支持不同的helper:WebDriver,Puppeteer,Protractor,Nightmare,Testcafe,我在项目上选用的是Puppeteer。

支持web也支持mobile,当时项目上的第一个产品是有手机端版本的,这也是选择这个工具的一个考虑。

封装良好的页面元素操作方法,拿来即用,对于不擅长编码的我来说,非常友好。

因为项目产品是和矿场上爆破紧密相关的,很多产品都有矿场地图展示和设备可视化,CodeceptJS提供了现成的codeceptjs-resemblehelper以实现视觉上的回归测试。

最近发现它还支持API测试,包括REST和GraphQL的,但是这部分特性尚未实践。

由于团队有完全的自由来选择技术栈,在做第三个产品的时候,我们的开发小哥哥就已经不满足于只写RESTAPI了,第三个产品开始引入GraphQL。在以前的项目上用过RESTAssured做API测试,觉得也是好用的,但当时并没有选用RESTAssured,因为在那时,刚好发现一枚ThouhgtWorks开发自己做的API功能测试工具Pandaria。(这也从侧面证明TW的开发很有质量意识)选择这个工具,除了自己不会造轮子,除了它支持代理,更重要的是它基于CucumberJVM,我个人以前的项目上用过cucumber,对gherkin语法还算熟悉,还有它能提供漂亮的测试报告。它既支持RESTAPI的测试,也支持GraphQL的测试,完美匹配我个人的技术和项目的实际情况。

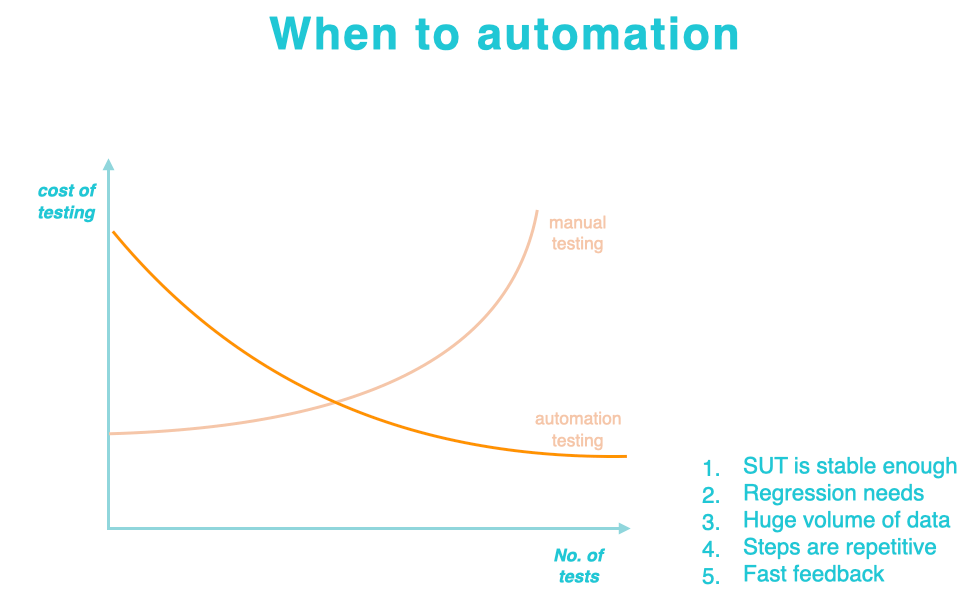

选择合适的时候做自动化,避免不必要的浪费。在项目做第一个规范安全流程的产品时,MVP1(MinimumViableProduct)一完成,该产品的接口自动化测试和端到端自动化测试便实现了,并集成到了产品CI/CD流水线上。后来由于客户方硬件集成的问题,该产品基于MVP1进行了一次演进,从产品直接融入并规范安全流程换成了‘曲线救国’地强化安全流程,页面和接口设计也有较大变动。由于产品流程设计上的变动导致之前的接口测试和端到端的自动化测试全部都失效,需要重新编写和维护。

这个经历挺真实的,自动化是有好处,但是也是有代价的:在MVP1,特别是POC(ProofOfConcept)阶段的产品建议不要急于做自动化,项目的初期更别尝试做UI层面的自动化。当然对工具的spike是可以的,把框架搭建好,等待特性稳定了,就可以直接加测试用例了。

我们选择自动化一定是要考虑项目是否存在客观的现实需求,在动手实施具体的自动化测试之前,一定要对自动化测试的投入产出比做一次客观理性地评估。如上图所示,自动化测试的成本相对单次(或者少量的)手动测试来说是较高的,为了少量的测试活动而做自动化,投入产出比是很低的。需要QA根据项目进度,产品演进程度,测试策略,回归频率等等做一个综合评估,找到出图中交集的点,即何时何种情况团队和产品应该必须引入自动化测试了。因为自动化前期需要投入产品分析,工具框架选型,用例设计,数据环境准备等等,后期还需要持续不断地投入人力进行及时的维护和更新以保证自动化测试的严密性和足够的覆盖率。

自动化测试和产品代码一样重要,需要全员负责。在交付一个微服务化的产品时,后端多个API,每个API有相应的API集成测试,产品还有UI测试,同时团队还有额外的3个产品需要维护。每个产品都有自动化测试,前端的后端的。其中一个微服务实现的产品就有四套测试,而且后续还会增加视觉测试。

如果只是QA一个人来维护管理,那么这个QA一定做不了自动化以外的事情了。ThoughtWorks好多项目都只有一个QA,我们的这个QA是QualityAnalyst,并不是AutomationEngineer。敏捷项目之下,QA的首要任务应该是驱动团队各个角色对质量负责。

为了提升团队对自动化测试的重视程度,如下是一些我个人在项目上实践过的方法:

为每套自动化测试编写清晰的README,保证团队里除你以外其他的小伙伴,也都清楚明白如何运行自动化测试。

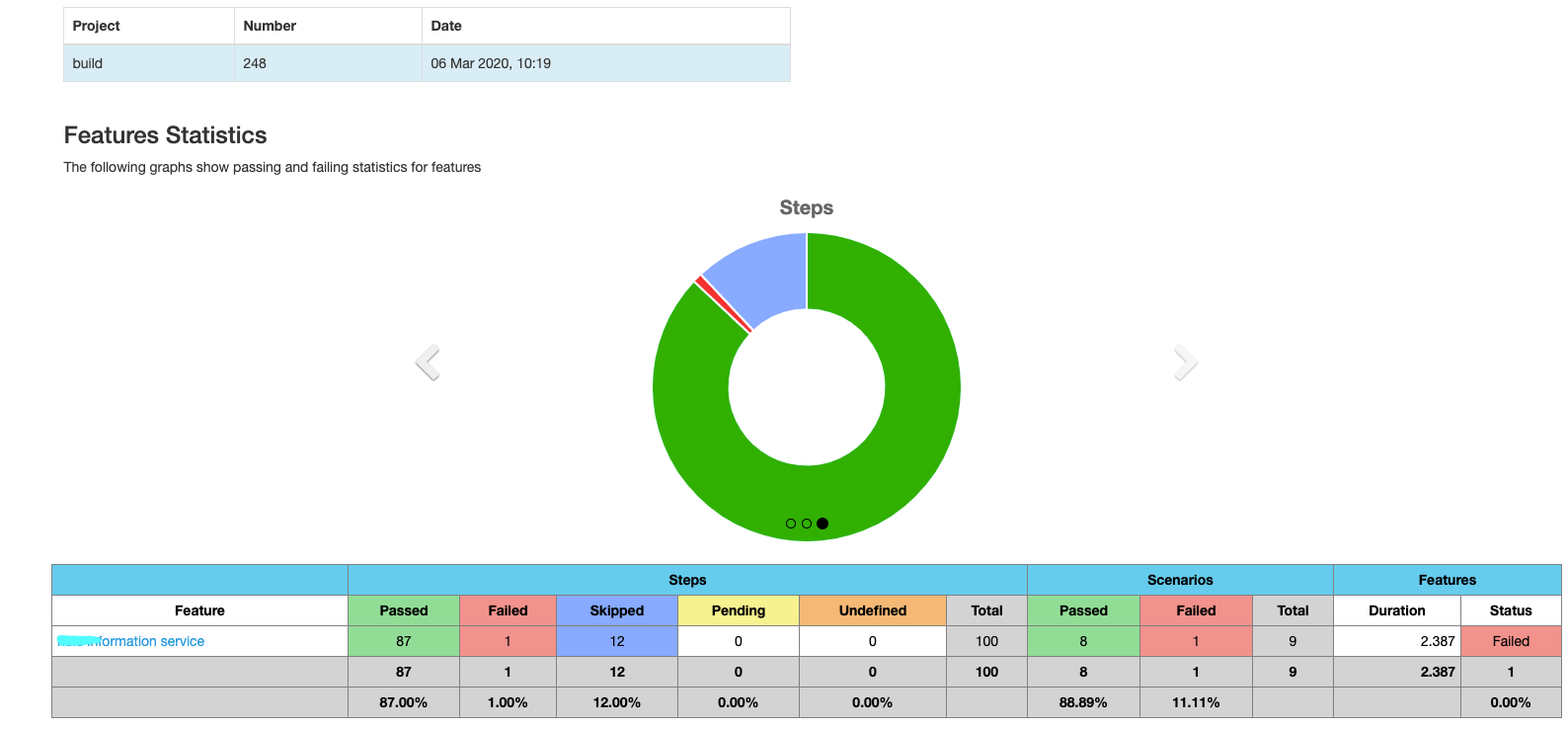

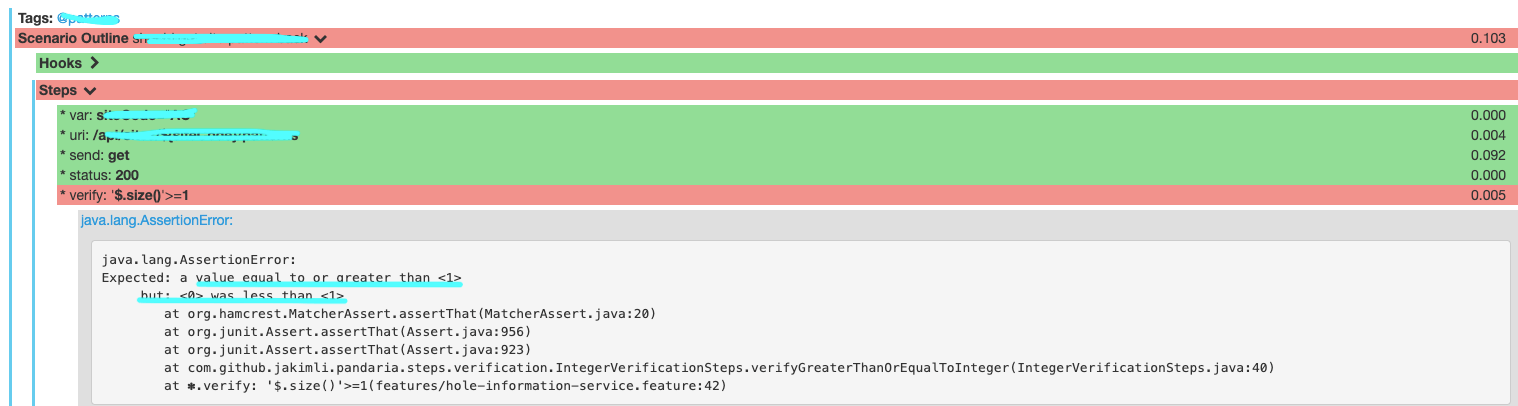

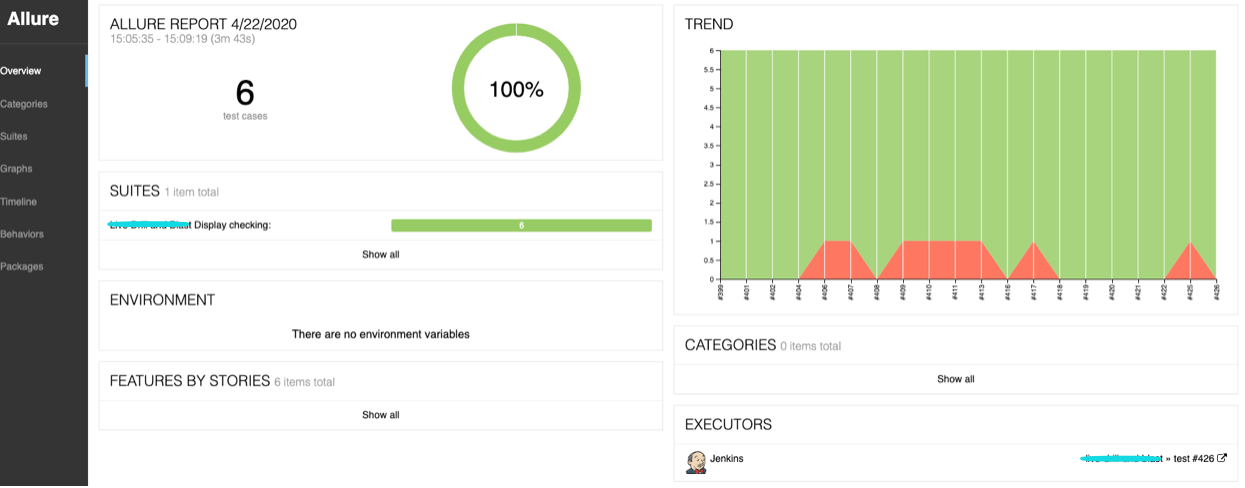

除了实用的README引导团队如何运行测试,可视化良好的测试报告也非常必要。如下是我们项目上的测试报告:

让UI测试更稳定,请求开发把页面的关键组件元素加上ID属性,用唯一的ID去定位元素就稳定多了。

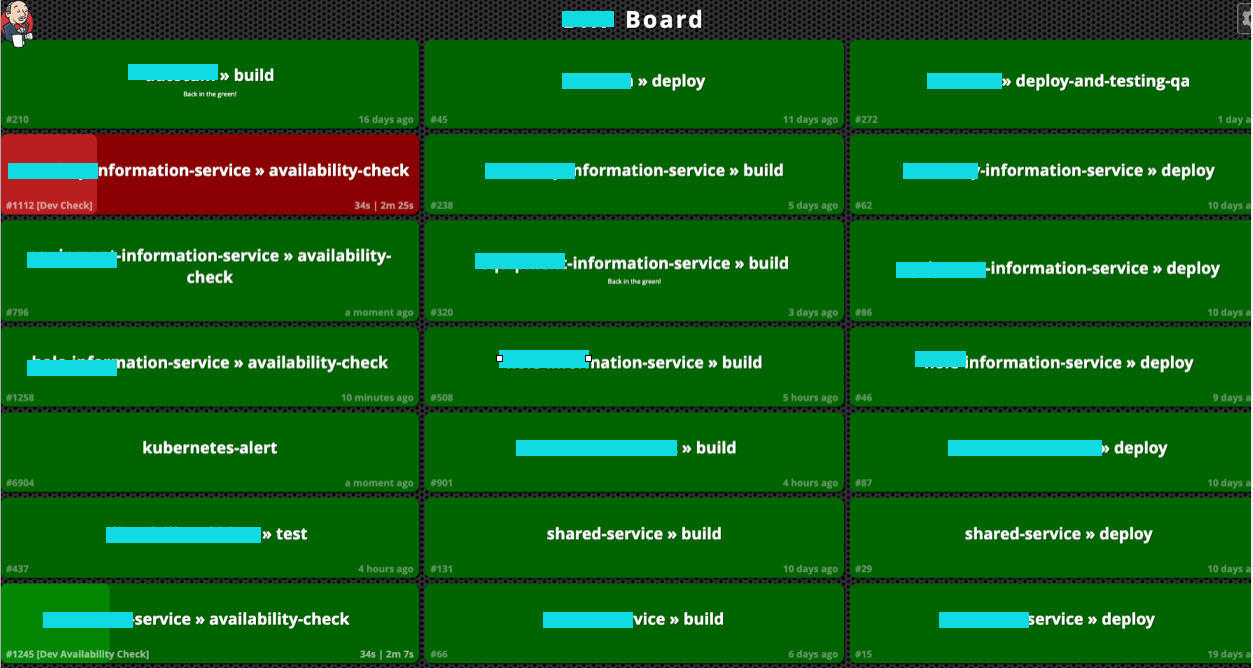

除了以上,项目还需要有高度可视化或者能及时通知测试状态的方式。

项目上用的是Jenkins自带的BuildMonitorView。将对项目pipeline的监控投影到电视上,并配置相应的提示音,能非常及时地让团队知道最新的构建,部署,测试状态。

如下是我们项目上当前的一个流水线dashboard:

这些实践都是对‘质量全员负责’最落地的践行。我相信,每个团队是不一样的,但是敏捷QA的主要价值一定是能驱动团队为质量作出改进和贡献。

敏捷QA是对项目流程质量,产品内部质量,产品外部质量都需要负责的,而自动化测试只是质量保证的一种措施而已而非唯一措施。‘质量全员负责’的团队才能释放出你们的QA,去做更多QualityAnalysis的工作,比如提更多需要思辨能力的问题以实现产品风险的识别和管理,反思开发流程以促进团队流程质量的提升,分析产品架构制定适合项目产品的整体测试策略等等。

持续测试除了自动化测试还需要QA和团队具备Devops相关的技术。在项目上做自动化集成到流水线的时候,有遇到一些常见的在云容器里运行测试会遇到的问题。

1)测试工具相关的

在容器里安装puppeteer之前,需要手动下载Chromium包以及相关的依赖。

在docker里面启动puppeteer,要么配置一个puppeteer的user,要么选择去掉默认的沙盒环境。

当时还遇到因为docker默认的64MB内存空间不够,Chrome渲染页面崩溃

虽然很多问题都是可以从网上找到答案,但是在解决问题的时候,通常需要我们了解工具框架的工作原理,否则连搜索关键字可能都憋不出来。

2)测试报告可视化相关的

测试报告对于我们快速定位失败根因有很大的帮助,好的测试报告可以直接揭示问题的根源。在云端运行测试,我们通常希望测试工具能输出可读性强的测试报告以方便非技术人员阅读,也希望测试工具能把运行过程的细节打印在console里,以方便技术人员定位根因。

像前面提到的CodeceptJS它就提供多种不同形态的运行,并且可以运用Mocha生成各种类型的测试报告。目前市面上的测试工具,都会有对第三方库的依赖,特别是前端测试框架和工具,这个对QA或者团队的技术宽度是有一定要求的。

另外Jenkins有非常丰富的插件库,在选择测试工具的时候可以把是否有Jenkins报告可视化支持考虑进去。QA需要对Jenkins和测试工具都相当熟悉,还需要知道如何通过将某一测试工具生成的某种格式的测试报告集成在Jenkins上以方便一键获取测试报告。像cucumber的测试报告插件:

像Allure的测试报告插件:

有了这些插件的辅助,在流水线上就一键可得测试报告,为‘质量团队负责’提供了很好的契机。

3)PipelineasCode,想要集成测试到流水线,不可避免是需要一些DevOps相关知识的

也许项目的需求是如何通过Jenkinsfile并行运行各种测试,也许是通过Jenkinsfile传递测试相关参数以为云上运行测试所用,还也许你需要在Jenkinsfile里添加调试信息用以线上调试,等等。

云上运行,我们还要学会如何在一个slave上优雅地管理运行测试的容器,不出现容器占用,slave内存不足,测试失败之后报告不可得等等问题。

所以只会自动化工具不够,只有自动化测试也不够。如果你们团队开发们没有DevOps的经验,或者他们忙于特性开发,上线冲刺,那么QA必须对Docker,Kubernetes基本命令和用法有些了解。QA就是一个不分前后端,不挑技术栈,需要持续不断学习的角色。

最后用个比喻结束这篇文章会自动化工具算是有了织网的道具,有自动化测试资产算是编出了能捞鱼的网,而持续测试才能真正地实现持续交付,才算是把一张张过滤不同缺陷的网放置于了不断提交变更的交付之流中。

只有网而无法至于河里,或者不知道于何处放置,那就只能站于岸边时时撒网捕鱼,不够及时,也不算释放了捕鱼人(QA和团队)。

我们期望的是,各种不同的网(自动化测试资产),置于不同的河段(软件产品不同层级:函数级别?组件级别?接口级别?系统级别?),过滤不同的鱼(缺陷),而不管是谁(团队的所有角色)都可以去确认有没有捞着鱼(测试挂了吗?为什么挂?我们对目前的变更有足够的信心吗?),也需要所有人时时确认我们的渔网是不是破了?(测试覆盖率不够?断言不严谨?测试用例过时?)。

软件交付是一项团队工作,即便自动化测试也一样需要全员协作。

文/ThoughtWorks郭泰瑜